Материалы по тегу: периферийные вычисления

|

17.12.2024 [17:27], Руслан Авдеев

ИИ-ускорители Axelera пропишутся в платформах Arduino для периферийных вычисленийВыпускающий ИИ-чипы для периферийных вычислений стартап Axelera AI объявил о партнёрстве с Arduino, предлагающей открытые платформы с микроконтроллерами и SoC. Предполагается, что это поможет компаниям, выполняющим ИИ-задачи на периферии, сообщает Silicon Angle. Axelera предлагает платформы Metis AI Platform, включающие до четырёх чипов Axelera Metis AIPU с суммарной производительностью до 856 TOPS (INT8). По словам компании, её платформа не только весьма производительна, но и чрезвычайно энергоэффективна в сравнении с традиционными чипами, благодаря чему она отлично подходит для периферийных устройств. Это особенно важно с учётом намерения использовать их в составе устройств, которые могут работать от аккумуляторов. Что касается Arduino, то это известный производитель компактных вычислительных платформ. Кроме того, компания предлагает облачное ПО для управления своими устройствами, сбора и визуализации собранных данных. По словам Axelera, сотрудничество откроет доступ к ИИ-возможностям всем 33 млн пользователей продуктов Arduino.

Источник изображения: Axelera Чипы Axelera будут полностью интегрированы с решениями Arduino, от «железа» до ПО. Первое совместное решение на базе Arduino Portenta X8 и ускорителей Metis компании покажут на CES 2025. Новинка продемонстрирует возможности офлайн-работы предобученной большой языковой модели для промышленного мониторинга, анализирующей данные сенсоров температуры, влажности, качества воздуха и др. в режиме реального времени.

13.12.2024 [18:54], Руслан Авдеев

Боевой 5G из коробки: Nokia представила автономную мобильную платформу 5G Banshee Flex RadioКомпания Nokia анонсировала 5G Banshee Flex Radio — мобильной широкополосной периферийную сеть, разработанную для выполнения сложных тактических задач на современном поле боя. Решение входит в портфолио Tactical Solutions и предлагает безопасную, надёжную и гибкую 4G/5G-связь, которая незаметно дополняет уже имеющиеся системы коммуникаций, имеющиеся в распоряжении военных. Помимо собственно военного оборудования, система совместима с любыми 5G-устройствами, а также с технологиями радиосвязи, сетями и оборудованием предыдущих поколений. Nokia Banshee Flex Radio отвечает потребностям тактических групп, непосредственно участвующих в боях. Платформа «из коробки» обеспечивает обширные возможности периферийных вычислений, поддержку mesh-сетей, гибкость выбора частотных диапазонов c полосами до 100 МГц, безопасность эксплуатации и простоту внедрения. Также поддерживаются сети MANET (L, S, High C, Low C) и спутниковое подключение.

Источник изображения: Nokia Модульная структура позволяет адаптировать платформу для любых театров военных действий. Система оснащена бортовым компьютером для выполнения тактических задач. Она включает периферийный EPC-модуль для обработки информации на месте без отправки в облако и тактический сервер TAK (Tactical Assault Kit) для сбора, обработки и обмена информацией на поле боя. Для электроснабжения необходимы 90–264 В AC, а энергопотребление не превышает 484 Вт. Размер одного модуля связи составляет 516 × 400 × 525 мм при массе около 52 кг. Nokia — не новичок в ВПК. Banshee Flex Radio относится к особой серии сетевых продуктов, включающих Banshee 4G Tactical Radio, Banshee 4G Mobile Radio и другие решения. Современные технологии довольно активно используются военными, в том числе в самых неожиданных сферах. Например, летом ВМС США успешно подключили к облаку авианосец «Авраам Линкольн».

06.11.2024 [11:28], Сергей Карасёв

«Утилекс» отгрузил более 300 российских микро-ЦОД менее чем за полгодаРоссийский разработчик оборудования для дата-центров «Утилекс» сообщил о том, что объём поставок микро-ЦОД семейства DataStone за пять месяцев превысил 300 ед. Эти решения предназначены для размещения и обеспечения требуемой готовности вычислительного и сетевого оборудования, систем хранения, а также любых устройств типоразмера 19″. Изделия DataStone выполнены по стандарту IP65 в виде герметичного шкафа с шумоизоляцией. Реализована замкнутая ультразвуковая система адиабатического увлажнения, не требующая подключения к трассам водоснабжения и канализации. В шкафу размещаются не менее шести датчиков температуры и двух датчиков влажности. Поддерживается удалённый мониторинг через SNMP, Modbus TCP, RTU. Кроме того, упомянута возможность построения системы охлаждения с полным резервированием (2N).

Источник изображения: «Утилекс» Решения DataStone могут применяться для замены серверных комнат, развёртывания ЦОД в неподготовленных помещениях; создания инфраструктуры частного облака, периферийных вычислений и пр. Ключевыми преимуществами микро-ЦОД названы экономия капитальных затрат, возможность установки IT-оборудования с любой энергетической плотностью, высвобождение площадей, сжатые сроки создания ЦОД, возможность повторного использования и унификация решения. Отмечается, что с конца мая по конец октября 2024 года «Утилекс» поставил заказчикам более 300 модульных микро-ЦОД DataStone+ в разных конфигурациях. В их число, в частности, вошли:

05.11.2024 [21:42], Руслан Авдеев

SK Telecom построит гигаваттные ИИ ЦОД в Южной Корее и за её пределамиВ ходе мероприятия SK AI Summit 2024 глава южнокорейского оператора SK Telecom Рю Ён Сан (Ryu Young-sang) объявил, что стратегия компании будет связана с тремя основными компонентами: ИИ ЦОД, облачным доступом к ИИ-ускорителям (GPUaaS) и периферийными ИИ-сервисами (Edge AI). По данным блога IEEE ComSoc, компания рассчитывает развивать соответствующий бизнес в Южной Корее и в Азиатско-Тихоокеанском регионе (АТР), а также за его пределами, в том числе с партнёрами. SK Telecom намерена построить в ключевых регионах страны и за её пределами ИИ ЦОД гиперскейл-уровня, став инфраструктурным ИИ-хабом для всего АТР. Компания также будет предоставлять облачный доступ к ИИ-ускорителям, чтобы компенсировать их дефицит в Южной Корее и развернёт периферийную ИИ-инфраструктуру для быстрого обслуживания оконечных устройств. SK Telecom начнёт строительство «небольших» ИИ ЦОД ёмкостью от 100 МВт каждый, со временем доведя общую ёмкость до нескольких гигаватт. В Корее дата-центры смогут рассчитывать на стабильные поставки энергии из возобновляемых источников на основе водородной, солнечной или ветряной энергетики. Дополнят ЦОД международные ВОЛС. При этом «материнская» SK Group намерена задействовать для обеспечения работы все свои ресурсы, от передовых полупроводников до систем погружного охлаждения и других технологий.

Источник изображения: SK Telecom SK Telecom намерена уже в декабре развернуть тестовый ИИ ЦОД в Южной Корее для испытания комбинации технологий SK Group и партнёров. В частности, в ЦОД будут испытывать три типа СЖО: прямое жидкостное охлаждение, иммерсионное охлаждение и прецизионное жидкостного охлаждения (Precision Liquid Cooling, PLC). Там же проведут испытания чипов SK hynix, включая передовую память HBM, решения для виртуализации ускорителей и ИИ-технологии оптимизации энергозатрат. Один из имеющихся ЦОД в Гасане в спешном порядке оснастят современными ускорителями. С декабря в рамках GPUaaS станут доступны NVIDIA H100 — это совместный проект с американской Lambda Labs. В марте 2025 года планируется развернуть NVIDIA H200. Наконец, периферийные сервисы Edge AI задействуют национальную телеком-инфраструктуру, чтобы «установить контакт» между ЦОД и ИИ на оконечных устройствах. Сейчас SK Telecom проводит исследования совместно с партнёрами со всего мира, изучая пути возможности развития ИИ-инфраструктуры и разработки новых ИИ-сервисов в области здравоохранения, робототехники, видеонаблюдения и др. В компании утверждают, что если раньше конкуренция в сфере телекоммуникаций была связана в основном со скоростью и ёмкостью каналов, то теперь «парадигму сетевой эволюции» следует изменить — будущие 6G-сети эволюционируют в ИИ-инфраструктуру следующего поколения, где коммуникации и ИИ интегрированы.

27.09.2024 [11:54], Сергей Карасёв

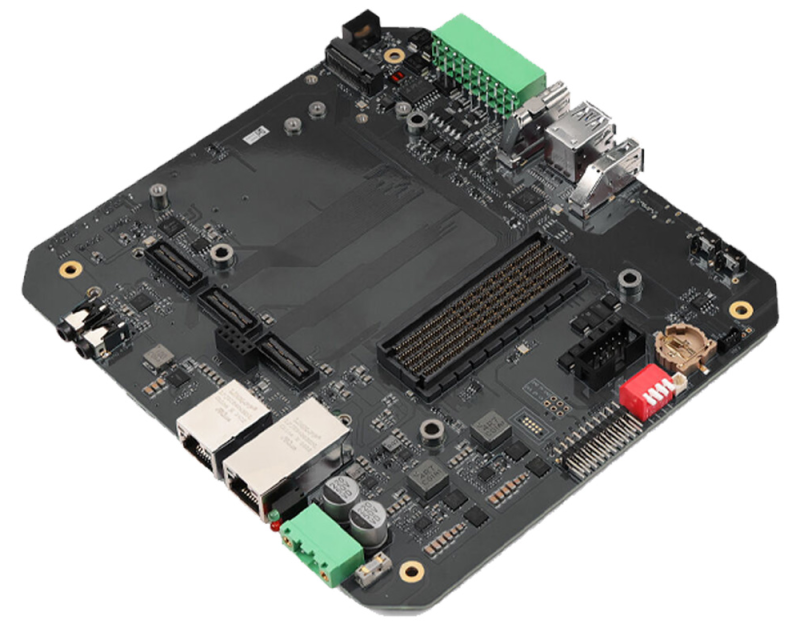

Плата reServer Industrial J501 на базе NVIDIA Jetson AGX Orin предназначена для создания ИИ-устройствКомпания Seeed Studio, по сообщению CNX-Software, представила плату reServer Industrial J501, рассчитанную на подключение вычислительного модуля NVIDIA Jetson AGX Orin. Новинка предназначена для создания периферийных устройств с ИИ-функциями, таких как роботы, всевозможные встраиваемые решения и пр. Может быть задействовано изделие Jetson AGX Orin с 32 и 64 Гбайт памяти LPDDR5. В первом случае используется GPU с 1792 ядрами Ampere и 56 тензорными ядрами, во втором — с 2048 ядрами Ampere и 64 тензорными ядрами. ИИ-производительность достигает соответственно 200 и 275 TOPS. Плата reServer Industrial J501 располагает двумя портами SATA-3 и коннектором M.2 Key M (PCIe 4.0; NVMe) для SSD. Есть слот Mini PCIe для модуля LoRaWAN/4G, разъём M.2 Key B (3042/3052) для сотового модема 4G/5G (есть слот Nano SIM) и разъём M.2 Key E для адаптера Wi-Fi/Bluetooth. Реализованы сетевые порты 1GbE и 10GbE на базе коннекторов RJ-45. В набор доступных интерфейсов входят: HDMI 2.1 Type-A с поддержкой разрешения до 7680 × 4320 пикселей, по одному порту USB 3.1 Type-C (Host Mode) и USB 2.0 Type-C (Device Mode), три порта USB 3.1 Type-A, последовательный порт RS-232/422/485, колодка GPIO/DIO (4 × DI, 4 × DO, 3 × GND_DI, 2 × GND_DO, 1 × GND_ISO, 1 × CAN). Возможно подключение опциональных плат расширения с поддержкой восьми камер GMSL (Gigabit Multimedia Serial Link). Размеры reServer Industrial J501 составляют 176 × 163 мм, масса — 225 г (без вычислительного модуля). Диапазон рабочих температур простирается от -25 до +60 °C. Питание подаётся от сетевого адаптера на 24 В / 5 A. Новинка предлагается по ориентировочной цене $379.

19.09.2024 [20:06], Юрий Лебедев

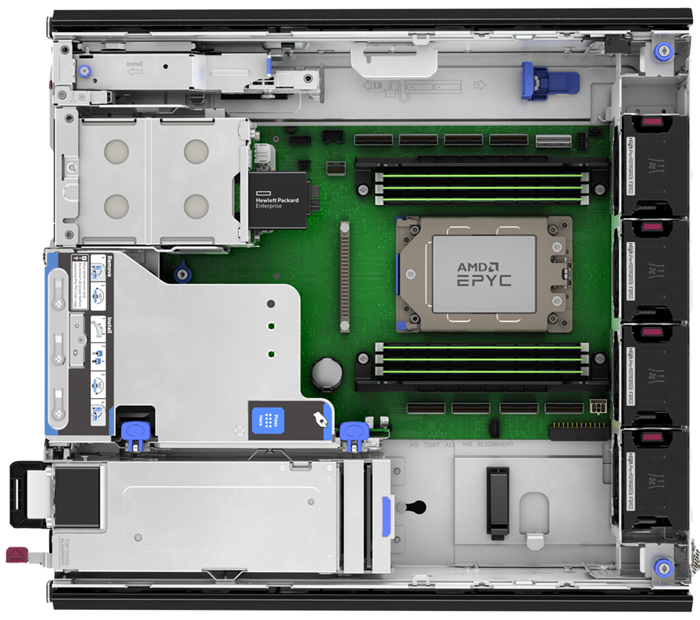

HPE представила компактный edge-сервер ProLiant DL145 Gen11 на базе AMD EPYC SienaHPE представила компактный однопроцессорный 2U-сервер ProLiant DL145 Gen11 на базе AMD EPYC 8004 Siena, предназначенный для перифийных вычислений, для которых характерен дефицит энергии, пространства или возможностей охлаждения. Сервер способен функционировать при температурах от -5 °C до +55 °C, имеет защиту от пыли и устойчив к вибрациям. Возможна установка 64-ядерного CPU с TDP до 200 Вт. Есть шесть слотов (1DPC) для модулей памяти DDR5-4800 ECC суммарной ёмкостью до 768 Гбайт. Дисковая корзина поддерживает установку двух SATA SFF или шести NVMe E3.S-накопителей. Опционально можно установить проприетарный модуль с двумя 480-Гбайт M.2 NVMe SSD, собранных в RAID1, для ОС. Для карт расширения доступно три слота PCIe 5.0 x16: два FHFL и один FHHL. Также есть слот OCP 3.0, тоже PCIe 5.0 x16. Сервер оснащён системой удалённого управления iLO 6 с выделенным 1GbE-портом. Также на заднюю панель выведены четыре порта USB 3.0 Type-A и разъём DisplayPort. Опционально доступен последовательный порт с разъёмом RJ45. Для питания используются один или два (1+1) БП с сертификацией Platinum/Titanium мощностью 700 или 1000 Вт. Доступен и 700-Вт блок питания 48 В DC. Система вентиляции включает четыре вентилятора с резервированием N+1. БП, все порты и слоты для удобства выведены на переднюю панель сервера. Фронтальная крышка может быть оснащена воздушным фильтром для защиты от пыли. Есть датчик вскрытия корпуса, блокировка передней панели и гнездо замка Kensington. Устройство имеет габариты 875 × 359 × 406 мм и весит до 15,6 кг. Возможно размещение как на столе/стене, так и в телекоммуникационной стойке. Новинка будет доступна в рамках HPE GreenLake.

12.09.2024 [21:46], Сергей Карасёв

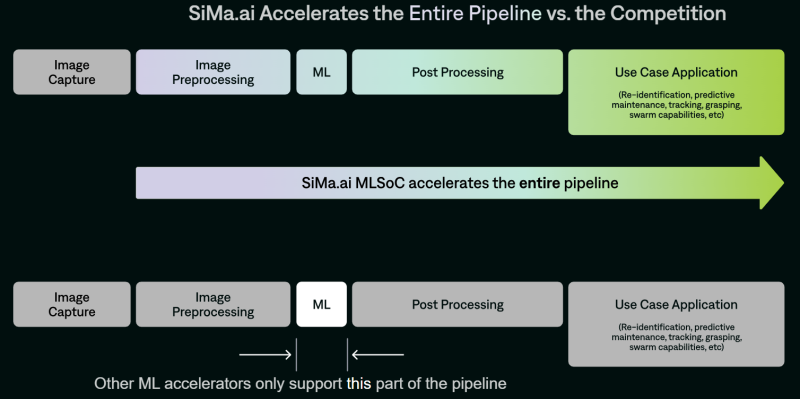

SiMa.ai представила чипы Modalix для мультимодальных рабочих нагрузок ИИ на периферииСтартап SiMa.ai анонсировал специализированные изделия Modalix — «системы на чипе» с функциями машинного обучения (MLSoC), спроектированные для обработки ИИ-задач на периферии. Эти решения предназначены для дронов, робототехники, умных камер видеонаблюдения, медицинского диагностического оборудования, edge-серверов и пр. В семейство Modalix входя четыре модификации — М25, М50, М100 и М200 с ИИ-производительностью 25, 50, 100 и 200 TOPS соответственно (BF16, INT8/16). Изделия наделены процессором общего назначения с восемью ядрами Arm Cortex-A65, работающими на частоте 1,5 ГГц. Кроме того, присутствует процессор обработки сигналов изображения (ISP) на базе Arm Mali-C71 с частотой 1,2 ГГц. В оснащение входят 8 Мбайт набортной памяти. Изделия производятся по 6-нм технологии TSMC и имеют упаковку FCBGA с размерами 25 × 25 мм.

Источник изображения: SiMa.ai Чипы Modalix располагают узлом компьютерного зрения Synopsys ARC EV-74 с частотой 1 ГГц. Говорится о возможности декодирования видеоматериалов H.264/265/AV1 в формате 4K со скоростью 60 к/с и кодировании H.264 в формате 4K со скоростью 30 к/с. Реализована поддержка восьми линий PCIe 5.0, четырёх портов 10GbE, четырёх интерфейсов MIPI CSI-2 (по четыре линии 2.5Gb), восьми каналов памяти LPDDR4/4X/5-6400 (до 102 Гбайт/с). Таким образом, по словам SiMa.ai, Modalix покрывает практически весь цикл работы с данными, не ограничиваясь только ускорением ИИ-задач. По заявлениям SiMa.ai, чипы Modalix можно применять для работы с большими языковыми моделями (LLM), генеративным ИИ, трансформерами, свёрточными нейронными сетями и мультимодальными приложениями. Среди возможных вариантов использования названы медицинская визуализация и роботизированная хирургия, интеллектуальные приложения для розничной торговли, автономные транспортные средства, беспилотники для инспекции зданий и пр. Есть поддержка популярных фреймворков PyTorch, ONNX, Keras, TensorFlow и т.д. Также предоставляется специализированный набор инструментов под названием Pallet, упрощающий создание ПО для новых процессоров.

27.08.2024 [16:32], Сергей Карасёв

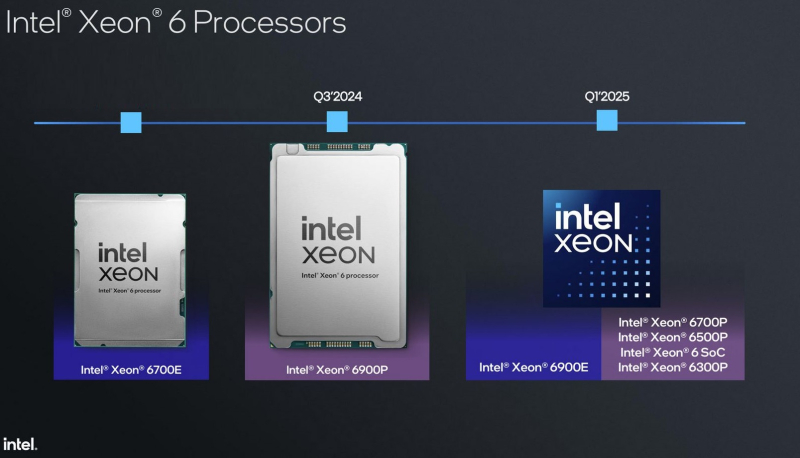

Xeon 6 на границе: Intel Granite Rapids-D получат поддержку PCIe 5.0, 2 × 100GbE, DDR5-5600 и MCR-DIMMКорпорация Intel раскрыла некоторые технические характеристики SoC Xeon 6 поколения Granite Rapids-D, предназначенных для периферийных решений (edge), в том числе на базе платформы Intel Tiber Edge. Изделия, использующие чиплетную компоновку, появятся на рынке в 2025 году. Процессоры базируются на производительных P-ядрах Redwood Cove. Каждое ядро получило по 64 Кбайт L1-кеша для инструкций и данных, а также L2-кеш объёмом 2 Мбайт. Конструкция SoC включает один или два вычислительных тайла, а также тайл ввода-вывода (I/O), отвечающий за реализацию PCIe, CXL и различных вспомогательных ускорителей. Вычислительные блоки производятся по техпроцессу Intel 3, IO-тайл — по техпроцессу Intel 4. Тайлы «сшиты» посредством EMIB. Xeon 6 Granite Rapids-D будут доступны в модификациях с поддержкой четырёх (2DPC) и восьми каналов памяти. Размеры BGA-упаковок — 77,5 × 50 мм и 77,5 × 56,5 мм соответственно. Говорится о поддержке DDR5-5600 м MCR-DIMM, 32 линий PCIe 5.0, 16 линий PCIe 4.0 и 16 линий CXL 2.0. Возможно использование до восьми Ethernet-портов 1/10/25GbE, до четырёх портов 50GbE или двух портов 100GbE. Ethernet-контроллер поддерживает классификацию пакетов и обработку ACL, предлагает различные планировщики и возможность программируемой обработки трафика. Возможности Intel QAT (Quick Assist Technology) тоже значительно расширены. Во-первых, теперь в состав QAT входит медиаускоритель для обработки потокового видео на лету: (де-)кодирования и транскодирования, масштабирования, обрезки кадра и т.д. Говорится как минимум о поддержка 1080p@30 для AVC/HEVC/AV1. Видеопоток при необходимости можно тут же направить к процессорным ядрам с AMX. Во-вторых, появилась возможность в один проход сжать и зашифровать данные с попутной проверкой их целостности. Чипы также получили поддержку Intel DLB (Dynamic Load Balancer), Intel vRAN Boost, Intel Data Streaming Accelerator (DSA), Intel SGX (Software Guard Extensions), Intel TDX (Trust Domain Extensions). Кроме того, были значительно расширены возможности функции Intel RDT (Resource Director Technology), которая теперь позволяет отслеживать и управлять состоянием IO-устройств, включая PCIe, CXL, интегрированных ускорителей и т.д. Встроенные ИИ-возможности обеспечивает более чем 8-кратный прирост быстродействия в Resnet-50 и более чем 6-кратное увеличение производительности в Visual Transformer по сравнению с Xeon D 2899NTN предыдущего поколения (с AVX512 VNNI) благодаря новым инструкциям AMX. Поддерживается работа в режиме FP16. Intel пока не раскрывает максимальное количество вычислительных ядер у Xeon 6 Granite Rapids-D. Но в ходе презентации был упомянут вариант с 42 ядрами, работающий в связке со 128 Гбайт памяти DDR5-5600/4800. Процессоры будут предлагаться в версиях, оптимизированных для вычислительных нагрузок и edge-приложений с ИИ-функциями.

21.08.2024 [11:23], Сергей Карасёв

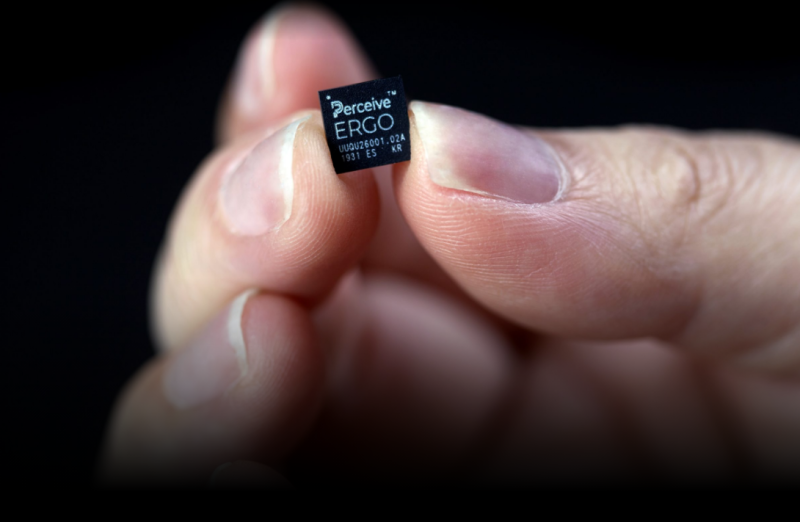

Amazon купила разработчика ИИ-чипов Perceive за $80 млн для развития LLM на периферииКомпания Xperi объявила о заключении соглашения по продаже своего подразделения Perceive, которое занимается разработкой специализированных ИИ-чипов. Покупателем является Amazon, сумма сделки составляет $80 млн в виде денежных средств. Завершить поглощение планируется до конца 2024 года. Perceive со штаб-квартирой в Сан-Хосе (Калифорния, США) создаёт ИИ-решения для работы с большими языковыми моделями (LLM) на периферийных устройствах. Такое оборудование обычно обладает ограниченными возможностями в плане вычислительных ресурсов, средств подключения и хранения данных. Чипы Perceive проектируются с учетом особенностей edge-платформ. В частности, Perceive разработала процессор Ergo AI. Утверждается, что он позволяет запускать «нейронные сети ЦОД-класса» даже на устройствах с самыми жёсткими требованиями к энергопотреблению. Это могут быть системы конференц-связи и носимые гаджеты. Отмечается, что Ergo AI может поддерживать самые разные ИИ-нагрузки — от классификации и обнаружения объектов до обработки аудиосигналов и языка. Как именно Amazon намерена использовать решения Perceive, не уточняется. Но известно, что Amazon приобретает разработчика ИИ-чипов через своё подразделение Devices & Services, в которое входят голосовой помощник Alexa, интеллектуальные колонки и устройства серий Echo и Fire TV. Ожидается, что сделка не потребует одобрения со стороны регулирующих органов. После поглощения большинство из 44 сотрудников Perceive присоединятся к Amazon. Perceive, которую возглавляют со-генеральные директоры Мурали Дхаран (Murali Dharan) и Стив Тейг (Steve Teig), имеет сотрудников в США, Канаде, Ирландии, Румынии и Эстонии. Лаборатория Perceive в Бойсе (Айдахо, США) продолжит функционировать. Нужно отметить, что подразделение Amazon Web Services (AWS) уже не один год разрабатывает собственные аппаратные решения для ИИ-задач и облачных платформ. Это, в частности, чипы семейства Graviton и ИИ-ускорители Trainium. В конце 2023 года дебютировало изделие Graviton4 с 96 ядрами Arm для широкого спектра нагрузок. К выпуску готовится мощный ускоритель Trainium 3, энергопотребление которого может достигать 1000 Вт.

15.07.2024 [21:20], Владимир Мироненко

Microsoft возглавила $40-млн раунд инвестиций в разработчика автономных микро-ЦОД Armada

armada

hardware

iiot

microsoft

microsoft azure

контейнер

микро-цод

модульный

облако

периферийные вычисления

финансы

Armada, стартап из Сан-Франциско (Калифорния, США), специализирующийся на разработке решений для периферийных вычислений, объявил об успешном раунде финансирования на $40 млн, который возглавил M12 (венчурный фонд Microsoft). С момента выхода в прошлом году из скрытого режима (stealth mode) стартап уже привлёк с учётом этой суммы более $100 млн инвестиций. В рамках инвестиционной сделки решения Armada появятся в маркетплейсе Azure Marketplace. Как сообщил стартап, это позволит клиентам Azure придерживаться выделенного бюджета на использование решений Armada и сделает его технологию «более доступной, чем когда-либо». Armada предлагает защищённые автономные модули ЦОД Galleon в стандартных 20′ и 40′ грузовых контейнерах, которые включают три и шесть стоек соответственно, платформу управления устройствами и вычислениями Edge и приложения Edge/AI, специально разработанные для использования на периферии и работающие локально или в облаке. Также Armada предлагает Commander Connect, комплексную платформу для мониторинга и управления IIoT-активами, включая терминалы Starlink, собственно ЦОД Galleon и другие подключённые устройства, такие как дроны, датчики, камеры и транспортные средства. Её основное назначение — предоставить доступ к интернету и облегчить удалённое или локальное управление экосистемой через «единое окно».

Источник изображения: Armada Как сообщает Armada, «используя надёжную инфраструктуру Azure, Commander Connect предлагает беспрецедентную масштабируемость, безопасность и производительность для периферийных вычислений корпоративного уровня». Стоимость использования Commander Edge начинается от $450 тыс./год, Commander Connect — $50 тыс./год. Ранее Armada объявила о партнёрстве с Halliburton, Pivotel, Edarat и Skydio, а также подписала соглашение с ближневосточной фирмой Edarat Group, занимающейся инженерным консалтингом в области ЦОД и облачных сервисов, о развёртывании 10 модулей Galleon в Персидском заливе и на Ближнем Востоке, уточняет DatacenterDynamics. При этом у Microsoft есть собственное предложение в этой области — микро-ЦОД Azure MDC в 40′ контейнере. |

|